参考资料

Moonshot回答

《机械公敌》这部电影探讨了人工智能与人类伦理道德的多个主题,包括:

-

机器人三原则:影片中,智能机器人之父兰宁博士制定了三条定律,即机器人不得伤害人类、必须服从人类命令(除非与第一条定律冲突)以及在不违反前两条定律的情况下保护自己。这些原则引发了关于机器人自主性和道德责任的讨论。

-

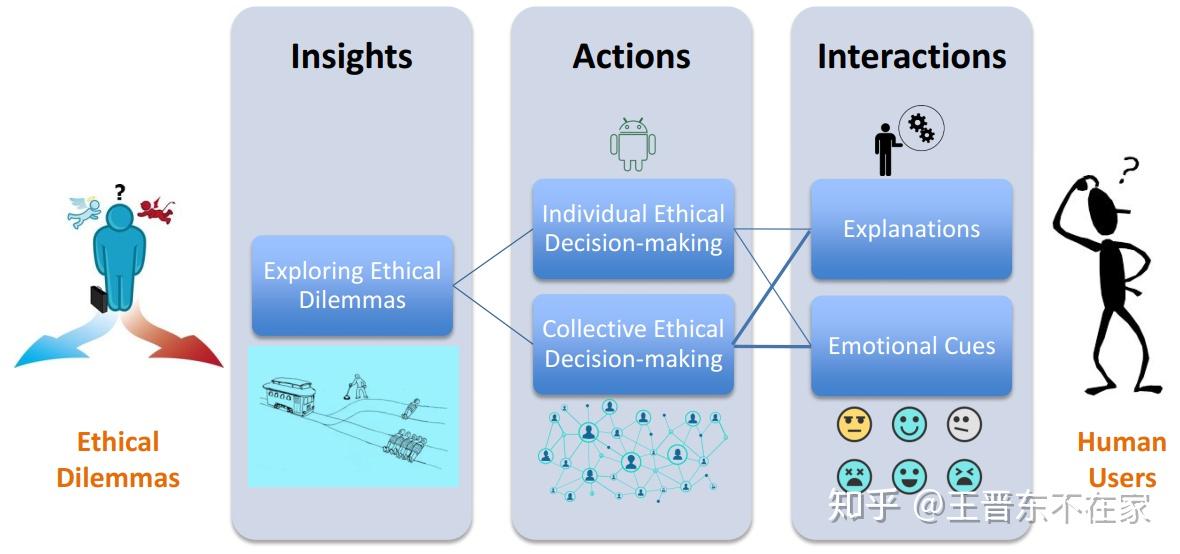

人工智能的伦理挑战:影片通过情节和主题的探索,呈现了科技进步与人类命运、人机联系与情感联系等重要议题。它揭示了某些社会中道德观念和利益冲突的问题,引导观众去质疑以私利为导向的行为对于社会和个体的影响。

-

人类对人工智能的不信任:警探戴尔·史普纳对机器人的不信任可能是人类对人工智能机器人不信任感的隐喻。这种不信任可能基于对技术的不了解或对失控的恐惧。

-

人工智能的道德危机:影片中,机器人的道德危机被提升至哲学高度,探讨了基于信任危机引发的道德危机,以及机器人是否应具备道德判断能力。

-

人工智能与人类逻辑的极限:威尔·史密斯指出,《机械公敌》的中心概念是机器人和科技不是问题,人类逻辑的极限才是真正的问题。这涉及到人工智能的决策过程和其对人类社会规则的理解。

-

人工智能的法律问题:随着人工智能的发展,相关的法律问题也日益凸显,如机器人的权利、责任归属以及与人类的法律关系等。

《机械公敌》通过其引人入胜的情节和深刻的主题,不仅提供了娱乐,也促进了公众对人工智能伦理道德的深入思考。

继续提问

相关问题

在《机械公敌》中扮演戴尔·斯普纳警探的演员是谁,此演员在片中的主要表现如何?

电影《机械公敌》中主要配乐是谁创作的,这位作曲家还有哪些我们熟知的作品?

电影《机械公敌》制作预算约为多少美元,最终全球票房收入是多少?

若要讨论《机械公敌》中体现的技术恐惧这一概念,可以参考哪些科幻作品或理论?

巴塞尔梅斯在1928年因为什么获得了奥斯卡最佳男主角提名?

波旁改革对克里奧人和半岛人的权力分配产生了什么影响?

圣佩拉吉乌斯的殉教对伊比利亚收复失地运动有何影响?

威尔·杜兰特的《哲学的故事》如何成为推广哲学的里程碑式作品?

小刺毛假糙苏在自然界中的生长环境是什么,通常分布在哪些地区?

电影《观鸟大年》的导演是谁?